تخلیه محاسباتی خودکار در لبه متحرک برای برنامه های اینترنت اشیاء

چکیده

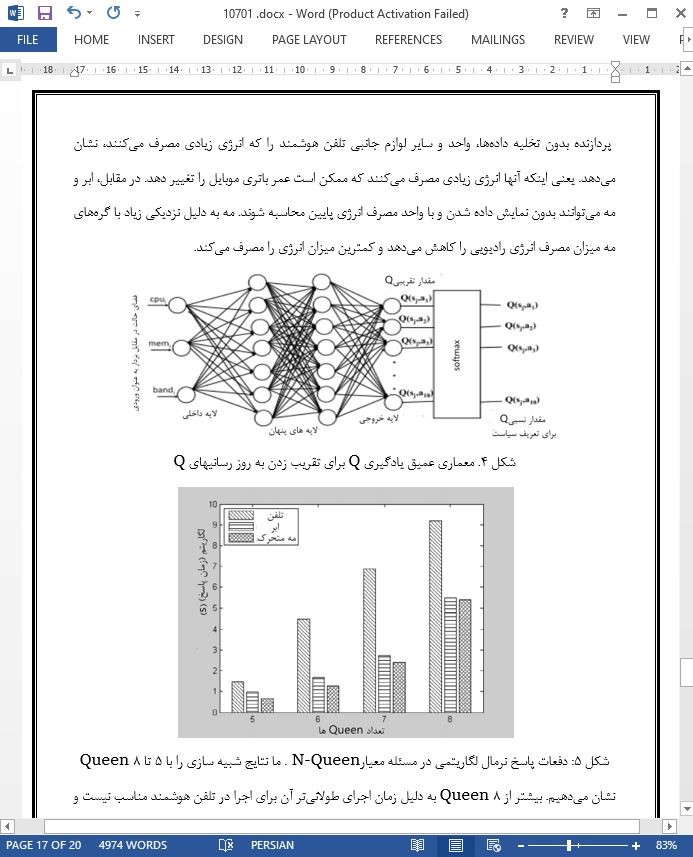

تخلیه محاسباتی یک توضیح برجسته برای دستگاههای سیار محدود به منابع است که انجام این فرایند مستلزم توانایی محاسباتی بالایی است. وجود ابر متحرک در پلتفرم تخلیه کاملاً شناخته شده است و بطور معمول در راه حلهای شبکهای بسیار دور برای استفاده در محاسبه دستگاههای سیار محدود به منابع بکار میرود. به خاطر راه حل شبکهای بسیار دور، دستگاههای کاربر، تأخیر شبکهای بالایی را تجربه میکنند که بر برنامههای اینترنت اشیاء (IOT) متحرک در زمان واقعی، تأثیر منفی دارد. بنابراین، این مقاله یک راه حل شبکهای بسیار نزدیک را برای تخلیه محاسباتی در مه/لبه متحرک پیشنهاد میدهد. تحرک، تنوع و توزیع جغرافیایی دستگاههای همراه از طریق چالشهای متعددی در تخلیه محاسباتی در مه/لبه متحرک. با این حال، برای پاسخگویی به تقاضای منابع محاسباتی در دستگاههای همراه بزرگ، یک چارچوب مدیریت خودکار مبتنی بر یادگیری عمیق Q مطرح میشود. کنترلگر لبه توزیع شده/ شبکه مه (FOC) که منابع مه/ لبه موجود برای مثال پردازش، حافظه، شبکه را پاکسازی میکند، سرویس محاسباتی مه/لبه را فعال مینماید. تصادفی بودن دسترس پذیری منابع و گزینههای بی شمار برای اختصاص آن منابع به محاسبه تخلیه، با مسئله مناسب برای مدلسازی از طریق روند تصمیم گیری Markov (MDF) و راه حل از طریق یادگیری تقویتی متناسب است. مدل پیشنهادی با توجه به نیازهای متغیر منابع و تحرک دستگاههای کاربر نهایی شبیه سازی شده است. روش پیشنهادی یادگیری عمیقQ، به طور قابل توجهی عملکرد تخلیه محاسباتی را از طریق به حداقل رساندن تأخیر در محاسبات سرویس، بهبود میبخشد. همچنین،کل نیرو با توجه تصمیم گیریهای مختلف تخلیه به منظور بررسیهای مقایسهای مورد مطالعه قرار گرفته است که این رویکرد پیشنهادی را با توجه به راه حلهای تخلیه محاسباتی پیشرفته، به عنوان یک رویکرد دارای مصرف بهینه انرژی نشان میدهد.

1. مقدمه

رشد فزایندۀ دستگاههای سیار (برای مثال، تلفنهای هوشمند، لپ تاپها، تبلت پی سی، IOT سیار واتومبیلها) و نیازهای محاسباتی آنها، موجب کاستیهای شدیدی در شبکههای ارتباطی و منابع محاسباتی شده است. برخی از سرویسهای نرم افزاری، برای مثال پردازش تصویر و خدمات ترجمه در زمان واقعی، مستلزم محاسبه گستردهای هستند، و دستگاههای سیار محدود به منابع نمیتوانند به آسانی برای پردازش آن برنامهها استفاده شوند. بنابراین، برای برآورده ساختن نیازهای محاسباتی چنین برنامهها و دستگاههای سیاری، برون سپاری محاسبه، امری لازم است.

6. نتیجه گیری

روش پیشنهادی افلودینگ کد مبتنی بر یادگیری عمیق Q، از رایانش ابری متحرک استفاده میکند. درحالیکه آن یک روش توزیع چندعاملی است، این عوامل با استفاده از تقویت کنندههای محیط آموزش میبینند. این روش تخلیه ، از بلوکهای اساسی در گرههای مه سازگار استفاده میکند تا از موازات آنها پشتیبانی کند. این نتایج آزمایشی، بهبود عملکرد روش تخلیه پیشنهادی در مورد زمان اجرا و تأخیر و مصرف انرژی را نشان میدهد.

Abstract

Computation offloading is a protuberant elucidation for the resource-constrained mobile devices to accomplish the process demands high computation capability. The mobile cloud is the well-known existing offloading platform, which usually far-end network solution, to leverage computation of the resource-constrained mobile devices. Because of the far-end network solution, the user devices experience higher latency or network delay, which negatively affects the real-time mobile Internet of things (IoT) applications. Therefore, this paper proposed near-end network solution of computation offloading in mobile edge/fog. The mobility, heterogeneity and geographical distribution mobile devices through several challenges in computation offloading in mobile edge/fog. However, for handling the computation resource demand from the massive mobile devices, a deep Q-learning based autonomic management framework is proposed. The distributed edge/fog network controller (FNC) scavenging the available edge/fog resources i.e. processing, memory, network to enable edge/fog computation service. The randomness in the availability of resources and numerous options for allocating those resources for offloading computation fits the problem appropriate for modeling through Markov decision process (MDP) and solution through reinforcement learning. The proposed model is simulated through MATLAB considering oscillated resource demands and mobility of end user devices. The proposed autonomic deep Q-learning based method significantly improves the performance of the computation offloading through minimizing the latency of service computing. The total power consumption due to different offloading decisions is also studied for comparative study purpose which shows the proposed approach as energy efficient with respect to the state-of-the-art computation offloading solutions.

1. Introduction

The massive growth of mobile devices (e.g. smart phones, laptops, tablet pc’s, mobile IoT’s and automobiles) and their computation demands imposed a huge scarcity in communication network and computation resources. Some of the application services e.g. image processing and real-time translation services require extensive computation, the resource-constrained mobile devices are not the feasible domiciles to process those applications. Therefore, to meet the computation demands of such type of mobile devices and applications the outsourcing of computation is the demand in need.

6. Conclusion

The proposed deep Q-learning based code offloading method leverage the mobile cloud computing. As it is a multi-agent based distributed method, agents learn from the environment through reinforcements. The offloading method deploys basic blocks in compatible fog nodes to support parallelism. The experimental results show the improved performance of the proposed offloading method in respect to execution time and latency and energy consumption.

چکیده

1. مقدمه

2. جدیدترین روشهای تخلیه محاسباتی

3. مدل سیستم رایانش مه متحرک

4. تخلیه محاسباتی خودکار مبتنی بر یادگیری عمیق Q

4.1 چارچوب آفلودینگ کد

4.2 فرایند تصمیم گیری مارکوف برای مدل یادگیری Q

4.3 تابع پاداش و یادگیری عمیق Q بر اساس تخلیه محاسباتی

5. ارزیابی عملکرد

6. نتیجه گیری

Abstract

1. Introduction

2. State-of-the-arts computation offloading methods

3. System model of mobile fog computing

4. Deep Q-learning based autonomic computation offloading

4.1. Code offloading framework

4.2. Markov decision process for deep Q-learning model

4.3. Reward function and deep Q-learning based computation offloading

5. Performance evaluation

6. Conclusion

- ترجمه فارسی مقاله با فرمت ورد (word) با قابلیت ویرایش، بدون آرم سایت ای ترجمه

- ترجمه فارسی مقاله با فرمت pdf، بدون آرم سایت ای ترجمه