بررسی ظرفیت شبکه های گسترده ارتباطی مراکز داده ابر عمومی در سراسر جهان

چکیده

با توجه به الگوهای ظرفیت فعلی، روند پژوهش ها، و آخرین گزارشات، ظرفیت شبکه های گسترده با گره های ابری توزیعشده در محل های جغرافیایی مختلف متصل به هم (به عنوان مثال شبکه بین مراکز داده) روز به روز بیشتر و بیشتر مورد توجه قرار گرفته اند. در این مقاله ما فقط رویکردهای فعال را بررسی کرده ایم (بنابراین ما به اطلاعات محدود ارائهدهندگان وابسته نیستیم) و به تجزیه و تحلیل عمیق این زیرساخت ها برای دو تامینکننده پیشرو ابر عمومی یعنی وب سایت خدماتی آمازون و مایکروسافت آزور می پردازیم. در این مقاله، یک ارزیابی از ظرفیت این شبکه ها به صورت تابعی از چندین فاکتور پیکربندی تحت کنترل مشتری و موارد خاص دیگری ارائه می شود. تجزیه و تحلیل این موارد و علل ریشه ای آن، و همچنین هزینه خدمات مرتبط، یک نگاه عمیق از تأثیر آن بر کیفیت خدمات دریافت شده توسط مشتریان ابر و نتایج مقالاتی که از آن ها چشم پوشی کرده اند در این مقاله فراهم شده است.

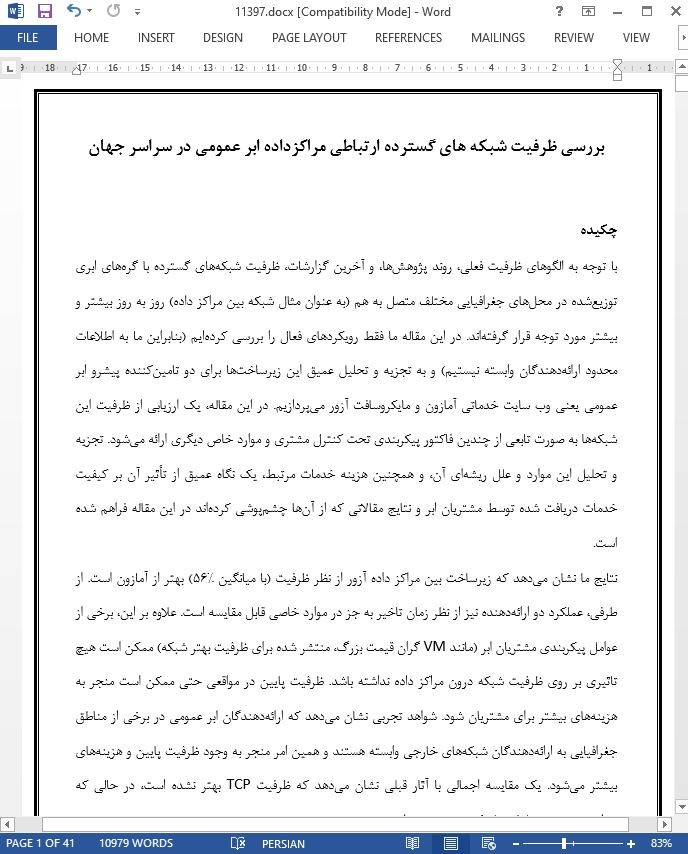

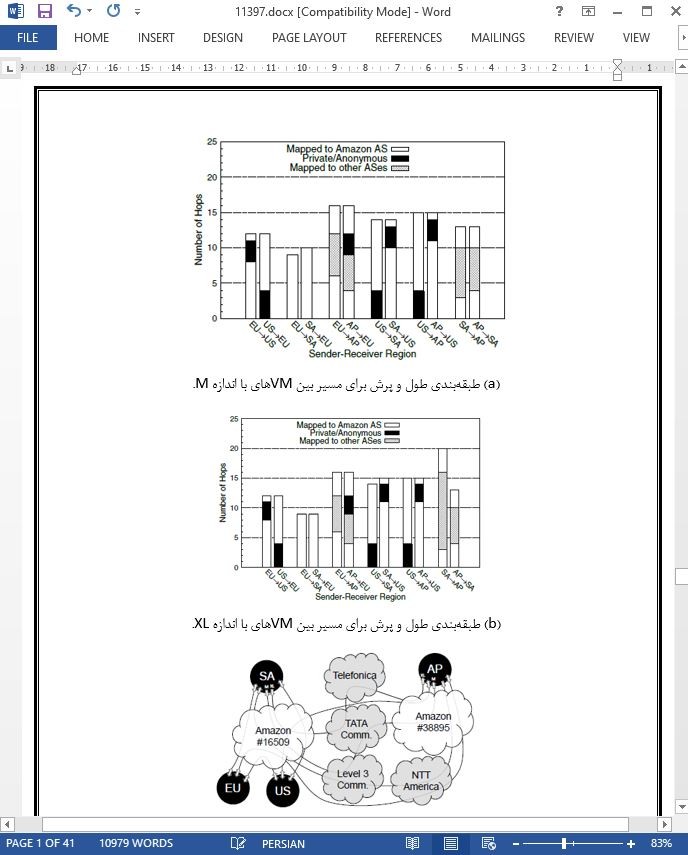

نتایج ما نشان می دهد که زیرساخت بین مراکز داده آزور از نظر ظرفیت (با میانگین 56%) بهتر از آمازون است. از طرفی، عملکرد دو ارائهدهنده نیز از نظر زمان تاخیر به جز در موارد خاصی قابل مقایسه است. علاوه بر این، برخی از عوامل پیکربندی مشتریان ابر (مانند VM گران قیمت بزرگ، منتشر شده برای ظرفیت بهتر شبکه) ممکن است هیچ تاثیری بر روی ظرفیت شبکه درون مراکز داده نداشته باشد. ظرفیت پایین در مواقعی حتی ممکن است منجر به هزینه های بیشتر برای مشتریان شود. شواهد تجربی نشان می دهد که ارائهدهندگان ابر عمومی در برخی از مناطق جغرافیایی به ارائهدهندگان شبکه های خارجی وابسته هستند و همین امر منجر به وجود ظرفیت پایین و هزینه های بیشتر می شود. یک مقایسه اجمالی با آثار قبلی نشان می دهد که ظرفیت TCP بهتر نشده است، در حالی که شواهدی مبنی بر ظرفیت لینک بیشتروجود دارد.

1. مقدمه

موسسات و سازمان های دولتی به طور فزاینده ای از راه حل های ابری برای عرضه خدمات از طریق اینترنت، و مقیاس بندی منابع در تقاضاها استفاده می کنند و فرصت های بی سابقه ای از نظر سهولت استفاده، کاهش هزینه و قابلیت اطمینان بیشتر را فراهم کرده اند [1]. در حال حاضر تعداد خدمات و برنامه های زیادی از طریق زیرساخت-های مبتنی بر ابر ارائه می شود، و تعداد زیادی از شرکت ها برای انجام کارهای مهم خود به ابر وابسته هستند. این وابستگی در مصرف کنندگان و کاربران انتهایی به شکل دسترسی همیشگی به دستگاه های متعدد ارائه دهنده سرویس ها و خدمات نمایان می شود.

6. نتیجه گیری

بر طبق آخرین پیش بینی های ترافیک ابر و روند تحقیقات اخیر، عملکرد شبکه بین مراکز داده ابری توزیع شده جغرافیایی محبوبیت زیادی پیدا کرده است. ما در این مقاله ابتدا عملکرد را از نظر ظرفیت و زمان تاخیر برای دو ارائهدهنده ابر عمومی پیشروی آمازون و آزور ارزیابی کردیم. سپس نتایج مورد علاقه را به تفصیل بررسی کردیم. نتایج تجربی نشان داد که چگونه آزور با هزینه کمتر از نظر ظرفیت قابل دستیابی (به طور متوسط بیشتر از 56٪)، عملکرد بهتری دارد. علاوه بر این، شواهد استقرار زیر ساخت های با کارایی بالا را در میان مراکز داده ابری برای هر دو ارائهدهنده آشکار کرده است: هر دو ارائهدهنده قادر به انتقال (UDP) ترافیک بین دو سایت جغرافیایی توزیع شده با سرعت 800 مگابیت بر ثانیه هستند.

Abstract

According to current usage patterns, research trends, and latest reports, the performance of the wide-area networks interconnecting geographically distributed cloud nodes (i.e. inter-datacenter networks) is gaining more and more interest. In this paper we leverage only active approaches—thus we do not rely on information restricted to providers—and propose a deep analysis of these infrastructures for the two public-cloud leading providers: Amazon Web Services and Microsoft Azure. Our study provides an assessment of the performance of these networks as a function of the several configuration factors under the control of the customer and evidences specific cases of particular interest. The analysis of these cases and of their root causes, also related with service fees, provides insights on their impact on both the Quality of Service perceived by cloud customers and the outcomes of studies neglecting them.

Our results show that Azure inter-datacenter infrastructure performs better than Amazon’s in terms of throughput (+56%, on average). On the other hand, the performance of the two providers is comparable in terms of latency, with the exception of limited specific cases. Moreover, some of the configuration factors cloud customers can leverage (such as larger more expensive VM sizes, advertised to have better network performance) may have no effect on the inter-datacenter network performance actually perceived. Counterintuitively, lower performance may even be related to higher costs for the customer. Experimental evidences show that public-cloud providers also rely on external network providers for some geographical regions, which is the cause of lower performance and higher costs. A comparison with previous works show that TCP throughput has not been improved recently, while evidences of higher link capacities have been found.

1. Introduction

Enterprise and government organizations increasingly leverage cloud solutions to supply services across the Internet, taking advantage of the ability to scale resources on demand and experimenting unprecedented opportunities in terms of ease of use, reduced costs, and higher reliability [1]. An increasing number of services and applications is now delivered through cloud-based infrastructures, and a large number of companies more and more depend on the cloud for mission critical workloads. For final consumers, this is reflected in ubiquitous access from multiple devices to content and services, delivered to almost anywhere users are located.

6. Conclusion

The performance of the network between geographicallydistributed cloud datacenters is gaining more and more interest, according to last cloud traffic forecasts, to cutting-edge solutions implemented and technologies developed by cloud providers, and to recent research trends. In this paper we have first provided a performance assessment in terms of throughput and latency for the two leading public cloud providers: Amazon and Azure. Then we have deepened the most interesting outcomes. Experimental results have shown how Azure performs better in terms of maximum achievable throughput (+56%, on average), for slightly higher costs. Moreover, evidences revealing the deployment of high performance infrastructures among cloud datacenters have been found for both providers: both are able to deliver (UDP) traffic between two geographically distributed sites at up to 800 Mbps.

چکیده

1. مقدمه

2. آثار مرتبط

3. روش کار

3.1. معماری مرجع

3.2. فاکتورهای شناسایی سناریوهای مورد علاقه

4. مجموعه داده تجربی

5. ظرفیت شبکه بین مرکز داده

5.1. ظرفیت TCP

5.2. میزان عبوردهی UDP و ظرفیت مسیر انتها به انتها

5.3. تغییرپذیری ظرفیت

5.4. مقایسه ظرفیت و هزینه ها

5.5. تاخیر

5.6. تاثیر در دسترس بودن منطقه

6. نتیجه گیری

Abstract

1. Introduction

2. Related work

3. Methodology

3.1. Reference architecture

3.2. Factors for identifying scenarios of interest

4. Experimental Dataset

5. Inter-datacenter network performance

5.1. TCP throughput

5.2. UDP throughput and end-to-end path capacity

5.3. Throughput variability

5.4. Performance vs. fees

5.5. Latency

5.6. Impact of the availability zone

6. Conclusion

- اصل مقاله انگلیسی با فرمت ورد (word) با قابلیت ویرایش

- ترجمه فارسی مقاله با فرمت ورد (word) با قابلیت ویرایش، بدون آرم سایت ای ترجمه

- ترجمه فارسی مقاله با فرمت pdf، بدون آرم سایت ای ترجمه