حملات مخالف به وسیله اتصال نشانگرهای پارازیت تصویر بر روی چهره در مقابل تشخیص چهره عمیق

چکیده

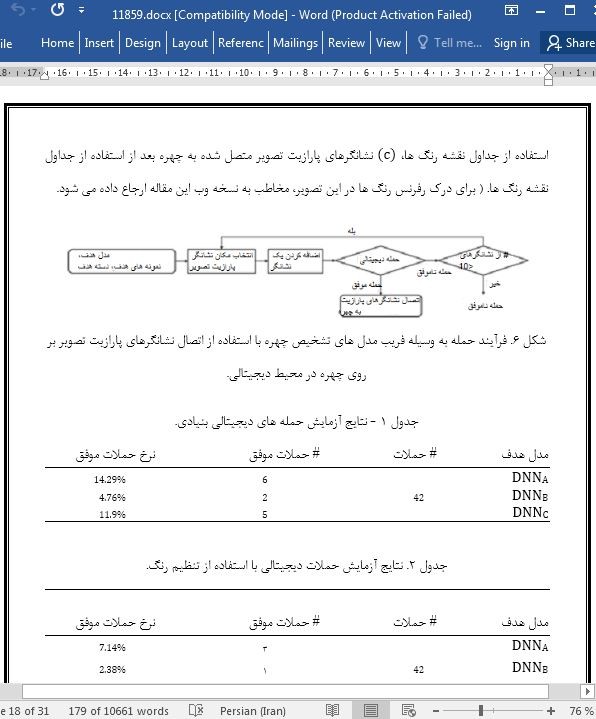

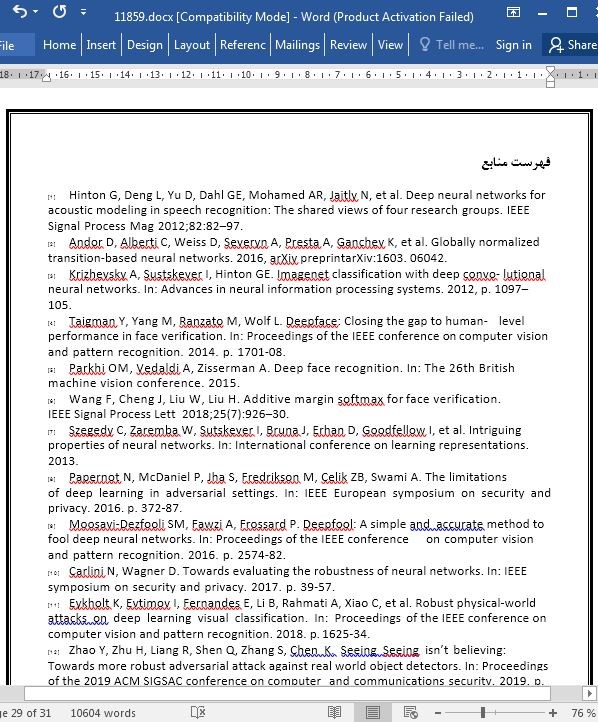

شبکه های عصبی عمیق هوش مصنوعی(DNNS) به طور فزاینده ای در فعالیت های آموزشی ماشینی موثر بوده اندکه این فعالیت ها شامل طبقه بندی تصاویر، تشخیص صدا، و پردازش زبان طبیعی است. تشخیص چهره با استفاده از DNNS کارایی بالایی دارد و به طور قابل ملاحظه در زمینه های گسترده ای از قبیل سیستم های مالی و بازرسی مهاجرتی مورد استفاده قرار می گیرد. با این حال شبکه عصبی یا همان DNNS نسبت به نمونه های تهاجمی که با اضافه کردن مقدار کمی پارازیت تصویر به نمونه اصلی به وجود می آید آسیب پذیر است که به طبقه بندی اشتباه در این سیستم می انجامد. در این مطالعه قصد داریم که پیشرفته ترین نرم افزار تشخیص چهره را با اتصال نشانگرهای پارازیت تصویر بر روی چهره در دنیای واقعی دچار خطا کنیم. به منظور به اشتباه انداختن یک مدل تشخیص چهره در دنیای واقعی، چالش های موجود در فرآیند حمله را مورد بررسی قرار می دهیم که این فرآیندها شامل تعیین مکان نشانگرهای پارازیت تصویر، تفاوت میان رنگ های نشانگرهای پارازیت دیجیتالی و رنگهای نشانگرهای پارازیت پس از پرینت، تفاوت های میان رنگ های نشانگرهای پارازیت که به چهره متصل شده اند و رنگ های نشانگرهای پارازیت پس از عکس برداری و تفاوت میان مکان های نشانگرهای دیجیتالی پارازیت و مکان های نشانگرهای پارازیت که به چهره متصل اند می باشد. در آزمایشات، ما نشانگرهای پارازیت را با در نظر گرفتن این چالش ها ایجاد کرده و نشان خواهیم داد که پیشرفته ترین مدل تشخیص چهره با اتصال حداکثر 10 نشانگر پارازیت به چهره دچار خطا می شود. این می تواند مدل های تشخیص چهره در شبکه های عصبی عمیق یا همان (DNNS) را با ریسک امنیتی مواجه کند.

7. نتیجه گیری

در این مطالعه چالش هایی که باید در فریب دادن مدل های تشخیص چهره با اتصال نشانگرهای پارازیت تصویر بر روی چهره ها در دنیای واقعی حل شوند را تعریف کرده و روش های فنی برای کاهش تفاوت های رنگ و تفاوت های مکان نشانگرهای پارازیت تصویر ارائه دادیم. به علاوه، سه روش برای انتخاب مکان های نشانگرهای پارازیت تصویر ارزیابی کرده و نشان دادیم که سیستم تشخیص چهره عمیق به وسیله اتصال حداکثر 10 نشانگر پارازیت تصویر 5 ×5 پیکسلی بر روی چهره در دنیای واقعی را می توان فریب داد. در تحقیقات آینده، از شرکت کنندگان بیش تری استفاده کرده و با استفاده از گروه داده جمع آوری شده با فیلمبرداری از مناطق مختلف و با تجهیزات متفاوت به انجام مطالعه می پردازیم. هم چنین، سعی خواهیم کرد که مدل های تشخیص چهره را با استفاده از استیکرهای نقاشی چهره که طبیعی تر بوده و ناحیه تغییر وسیع تری نسبت به نشانگرهای پارازیت تصویر دارند، فریب دهیم و تلاش می کنیم که به سیستم های تشخیص چهره بازرگانی مانند Face++[43] و Rekognition[44] حمله کنیم.

Abstract

Deep neural networks (DNNs) have become increasingly effective in difficult machine learning tasks, such as image classification, speech recognition, and natural language processing. Face recognition (FR) using DNNs shows high performance and is widely used in various domains such as payment systems and immigration inspection. However, DNNs are vulnerable to adversarial examples generated by adding a small amount of noise to an original sample, resulting in misclassification by the DNNs. In this study, we attempt to deceive state-of-the-art FR by attaching noise markers on a face in the real world. To deceive an FR model in the real world, we address challenges in the attack process, including selection of locations of noise markers, the differences between colors of digital noise markers and those of noise markers after printing, the differences between the colors of noise markers that are attached to the face and those of noise markers after a picture is taken, and the differences between the locations of digital noise markers and those of noise markers that are attached to the face. In experiments, we generate noise markers considering these challenges and show that state-of-the-art FR can be deceived by attaching a maximum of 10 noise markers to a face. This can cause a security risk for FR models using DNNs.

7. Conclusion

In this study, we defined the challenges that must be solved when deceiving deep FR models by attaching noise markers on faces in the real world and demonstrated technical approaches to minimize color differences and location differences of the noise markers. In addition, we evaluated three methods for selecting the locations of the noise markers and showed that the deep FR system could be deceived by attaching a maximum of 10 noise markers of 5 × 5 pixels on the face in the real world. In future research, we will recruit more participants and conduct the study with face datasets collected under various shooting environments using different devices. In addition, we will attempt to deceive FR models using face painting stickers that are more natural and have a wider modulation area than noise markers, and will try to attack commercial FR systems such as Face++ [43] and Amazon Rekognition [44].

چکیده

1. مقدمه

2. پیش زمینه

1.2. تشخیص چهره عمیق

2.2. طبقه بندی حمله در مقابل تشخیص چهره عمیق

3. مطالعات مربوط

1.3. حملات تهاجمی برای دسته بندی تصاویر

2.3. حملات رقابتی علیه تشخیص چهره عمیق

4. روش فنی

1.4. تعریف چالش

2.4. انتخاب مکان نشانگر پارازیت تصویر

3.4. تنطیم رنگ و مکان

5. ارزیابی

1.5. مقدمه آزمایش

2.5. گزینش مکان نشانگر پارازیت تصویر

3.5. آزمایش ها در محیط دیجیتالی

4.5. آزمایش در دنیای واقعی

5.5. حملات انتقال پذیر

6. بحث و گفتگو

7. نتیجه گیری

منابع

Abstract

1. Introduction

2. Background

2.1. Deep face recognition

2.2. Attack category against deep face recognition

3. Related work

3.1. Adversarial attacks for image classification

3.2. Adversarial attacks against deep face recognition

4. Technical approach

4.1. Challenge definition

4.2. Selecting noise marker location

4.3. Color and location calibration

5. Evaluation

5.1. Experiment setup

5.2. Selection of noise marker location

5.3. Experiments in digital environment

5.4. Experiments in the real world

5.5. Transferability attacks

6. Discussion

7. Conclusion

References

- ترجمه فارسی مقاله با فرمت ورد (word) با قابلیت ویرایش، بدون آرم سایت ای ترجمه

- ترجمه فارسی مقاله با فرمت pdf، بدون آرم سایت ای ترجمه