دانلود رایگان مقاله روش های اخیر در تشخیص حرکات و اشارات دست مبتنی بر بینایی

چکیده

تلاش های موفق در تحقیقات تشخیص حرکات و اشارات دست در طی دو دهه گذشته, راه را برای سیستم های تعامل طبیعی انسان-کامپیوتر هموار کرده است. چالش های حل نشده مانند شناسایی قابل اعتماد فاز ژست گرفتن، حساسیت به اندازه، شکل و تغییرات سرعت و مسائل ناشی از انسداد، تحقیقات در مورد تشخیص ژست دست را هنوز بسیار فعال نگهداشته است. ما یک بررسی از الگوریتم های تشخیص ژست دست مبتنی بر بینایی که در 16 سال گذشته گزارش ارائه می دهیم. روش های استفاده کننده از دوربین های RGB و RGB-D با مقایسه های کمی و کیفی الگوریتم ها بررسی می شوند. مقایسه کمی الگوریتم ها با استفاده از مجموعه ای از 13 معیار انتخاب شده از صفات مختلف الگوریتم و روش تجربی اتخاذ شده در ارزیابی الگوریتم انجام می شود. ما به لزوم در نظر گرفتن این معیارها همراه با دقت تشخیص الگوریتم برای پیش بینی موفقیت آن در کاربردهای دنیای واقعی اشاره می کنیم. این مقاله همچنین به بررسی 26 پایگاه داده ژست دست در دسترس عموم و ارائه لینک های وب برای دانلود آنها می پردازد.

1. مقدمه

ارتباطات غیرشفاهی که شامل ارتباطات از طریق حرکات دست، حالات بدن و بیان های چهره می شود، حدود دو سوم کلیه ارتباطات بین انسان ها را تشکیل می دهد [1]. حرکات دست یکی از رایج ترین انواع زبان بدن هستند که برای ارتباط و تعامل استفاده می شوند. در حالی که بقیه بدن, نشان دهنده یک حالت عمومی تر عاطفی است، حرکات دست می توانند محتوای زبان خاص خود را در آن داشته باشند (2). با توجه به سرعت و ظرافت در تعامل، حرکات دست به طور گسترده در زبان های اشاره و سیستم های تعامل انسان-کامپیوتر استفاده می شود.

یک هدف مداوم در طراحی واسطه انسان-دستگاه، میسر ساختن تعامل موثر و درگیرانه است. به عنوان مثال، سیستم های تشخیص حرکت دست مبتنی بر بینایی (HGR) می توانند تعامل بدون تماس در محیط های استریل مانند اتاق های جراحی بیمارستان را میسر سازند یا به سادگی کنترل های درگیرانه برای برنامه های سرگرمی و بازی را فراهم کنند. با این حال HGR به اندازه تعامل مبتنی بر صفحه کلید و موس استاندارد, قوی نیست. مسائلی مانند حساسیت به اندازه و تغییرات سرعت، عملکرد ضعیف در برابر پس زمینه های پیچیده و شرایط مختلف نوردهی و تشخیص قابل اعتماد از فاز ژست، استفاده از حرکات دست را به عنوان یک روش معتبر در طراحی واسطه محدود کرده اند.

1.1 طبقه بندی ژست ها

روش های متعددی برای دسته بندی حرکات (ژست های) دست وجود دارد: 1) بر اساس ویژگی های قابل مشاهده و 2) بر مبنای تفسیر. در رده اول, حرکات براساس روابط زمانی، به دو نوع طبقه بندی می شوند: حرکات ایستا و پویا (شکل 1). حرکات استاتیک دست (مثلاً حالت های دست/ ژست های دست), حرکاتی هستند که در آن, موقعیت دست در طول دوره ژست گیری تغییر نمی کند. حرکات استاتیک عمدتاً بر روی شکل و زوایای خمش انگشتان تکیه می کنند. در حرکات پویای دست، موقعیت دست به طور مداوم با توجه به زمان تغییر می کند. حرکات پویا عموماً سه مرحله حرکتی دارند: آماده سازی، ضربه، و انقباض [3]. پیام در یک ژست پویا عمدتاً در دنباله زمانی در مرحله ضربه گنجانده می شود. حرکات پویا بر روی مسیرها و جهت های دست، به علاوه شکل و زاویه های خمش انگشت تکیه می کنند.

در رده دوم، حرکات بر اساس معنای تفسیری طبقه بندی می شوند. به عنوان مثال، نمادها، تصویرگرها، تنظیم کننده ها، نمایشگرها و آداپتورها [4، 5], کلاس های معمول برای توصیف حرکات هستند. نشان ها (که همچنین به عنوان حرکات خود به خودی نامگذاری می شوند) حرکاتی هستند که می توانند برای کلمات گفتاری جایگزین شوند (به عنوان مثال، نشان دادن انگشت های شست رو به بالا به جای گفتن اینکه: بسیار خوب). تصویرگرها, ژست های مورد استفاده برای نشان دادن کلمات گفته شده هستند (مثلاً جهت دادن با اشاره). تنظیم کننده ها از تعامل و ارتباط بین سخنران و شنونده (به عنوان مثال، بالا بردن دست برای مدیریت نوبت گرفتن) پشتیبانی می کنند. نمایش های اثر, ابرازات چهره ای هستند که در هنگام ترکیب با حالت ها، شدت یک احساس را نشان می دهند (به عنوان مثال، برجسته کردن یک شی و حرکت بدن به پشت، منعکس کننده احساس ترس). تطبیق دهنده ها, حرکات مورد استفاده در برخی مواقع برای راحتی شخصی هستند اما به عادت تبدیل شده اند (برای مثال، تنظیم عینک ها در یک وضعیت تنگ شده).

1.2 تشخیص ژست دست

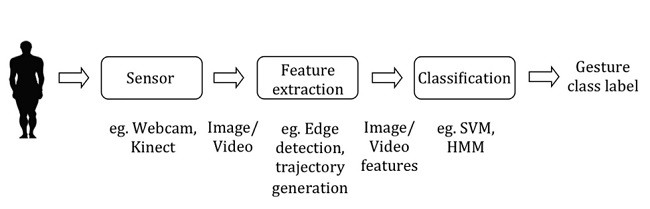

شکل 2, بلوک دیاگرام یک سیستم تشخیص ژست بدون تماس نوعی را نشان می دهد. سنسور, یک دوربین در سیستم های تشخیص ژست مبتنی بر بینایی است. Berman و همکاران [6], سنسورهای مختلف مورد استفاده در سیستم های تشخیص حرکت را مورد بررسی قرار دادند و یک تحلیل جامع از ادغام سنسورها را در سیستم های تشخیص حرکت و تاثیر آنها بر عملکرد سیستم ارائه کردند. بر اساس استخراج ویژگی، سیستم های تشخیص ژست مبتنی بر بینایی به طور گسترده به دو دسته تقسیم می شوند, روش های مبتنی بر ظاهر و روش های مبتنی بر مدل سه بعدی دست (3D). روش های مبتنی بر ظاهر از ویژگی های تصویر آموزش برای مدلسازی ظاهر بصری استفاده می کنند و این پارامترها را با ویژگی های تصویر آزمون مقایسه می کنند. روش های سه بعدی مبتنی بر مدل با تخمین پارامترهای خطی و زاویه ای مدل, بر یک مدل سینماتیک سه بعدی تکیه می کنند.

1.3 بررسی و ارزیابی تکنیک های تشخیص ژست دست

مطالعه ما بر اساس تلاش های پیشین برای بررسی حوزه HGR استوار است. Mitra و همکاران [7], یک پیمایش از روش های مختلف تشخیص ژست، شامل ژست های دست و بازو، ژست های سر و صورت و حرکات بدن را ارائه کردند. روش های HGR بررسی شده در این تحقیق محدود به مدل های مخفی مارکوف (HMM)، الگوریتم های فیلتر کردن ذرات و تراکم و شبکه های عصبی مصنوعی (ANN) بودند. روش های برآورد ژست مبتنی بر مدلسازی دست و مبتنی بر حرکت سه بعدی در [8] (با نادیده گرفتن طرح های طبقه بندی ژست) مورد بررسی قرار گرفته اند. یک تجزیه و تحلیل از زبان های نشانه، فرآیندهای دستوری در ژست های نشانه و مسائل مربوط به شناخت خودکار زبان های نشانه در [9] بحث شده اند. آخرین مقالات فوق (8), توسعه ها تا ژانویه 2005 را پوشش دادند. این بررسی نتیجه گیری کرد که روش های مورد مطالعه, آزمایشگاهی هستند و استفاده از آنها محدود به محیط های آزمایشگاهی می شود.

با تمرکز بر تحولات در 16 سال گذشته, این مقاله به بررسی کارهای اخیر در HGR می پردازد. الگوریتم های استفاده کننده از دوربین های RGB معمولی (بخش 2) و همچنین دوربین های RGB-D نسل جدید (بخش 3) مورد بررسی قرار می گیرند که این بررسی را منحصر به فرد می سازند. روش های HGR , با توجه به روش استفاده شده برای طبقه بندی ژست طبقه بندی و تجزیه و تحلیل می شوند. ما یک مقایسه کمی از الگوریتم های HGR را بر اساس صفات مختلف الگوریتم و روش آزمایشگاهی دنبال شده در آزمایش الگوریتم انجام می دهیم. یک بازنگری در پایگاه های داده ژست دست (بخش 4) و بحث در مورد تحقیقات تشخیص ژست دست (بخش 5) نیز ارائه شده است. ما امیدواریم که این بررسی، با توجه به تلاش های تحقیقاتی روز افزون و گسترش بازار برای سیستم های تعاملی ژست به موقع باشد.

Abstract

Successful efforts in hand gesture recognition research within the last two decades paved the path for natural human–computer interaction systems. Unresolved challenges such as reliable identification of gesturing phase, sensitivity to size, shape, and speed variations, and issues due to occlusion keep hand gesture recognition research still very active. We provide a review of vision-based hand gesture recognition algorithms reported in the last 16 years. The methods using RGB and RGB-D cameras are reviewed with quantitative and qualitative comparisons of algorithms. Quantitative comparison of algorithms is done using a set of 13 measures chosen from different attributes of the algorithm and the experimental methodology adopted in algorithm evaluation. We point out the need for considering these measures together with the recognition accuracy of the algorithm to predict its success in real-world applications. The paper also reviews 26 publicly available hand gesture databases and provides the web-links for their download.

1. Introduction

Nonverbal communication, which includes communication through hand gestures, body postures, and facial expressions makes up about two-thirds of all communication among human [1]. Hand gestures are one of the most common category of body language used for communication and interaction. Whilst the rest of the body indicates a more general emotional state, hand gestures can have specific linguistic content in it [2]. Due to the speed and expressiveness in interaction, hand gestures are widely used in sign languages and human–computer interaction systems.

One ongoing goal in human–machine interface design is to enable effective and engaging interaction. For example, vision-based hand gesture recognition (HGR) systems can enable contactless interaction in sterile environments such as hospital surgery rooms, or simply provide engaging controls for entertainment and gaming applications. However HGR is not as robust as standard keyboard and mouse based interaction. Issues such as sensitivity to size and speed variations, poor performance against complex backgrounds and varying lighting conditions, and the reliable detection of gesturing phase have limited the use of hand gestures as a reliable modality in interface design.

1.1. Taxonomy of gestures

There are multiple ways to categorize hand gestures, (1) based on observable features and (2) based on the interpretation. In the first category gestures are classified based on temporal relationships, into two types; static and dynamic gestures (Fig. 1). Static hand gestures (aka hand postures/hand poses) are those in which the hand position does not change during the gesturing period. Static gestures mainly rely on the shape and flexure angles of the fingers. In dynamic hand gestures, the hand position changes continuously with respect to time. Dynamic gestures generally have three motion phases: preparation, stroke, and retraction [3]. The message in a dynamic gesture is mainly contained in the temporal sequence in the stroke phase. Dynamic gestures rely on the hand trajectories and orientations, in addition to the shape and fingers’ flex angles.

In the second category, gestures are classified based on the interpreted meaning. For example emblems, illustrators, regulators, affect displays, and adaptors [4,5] are the typical classes to describe gestures. Emblems (also labeled as autonomous gestures) are gestures that can be substituted for spoken words (for example, showing thumbs-up instead of saying all right). Illustrators are gestures used to illustrate spoken words (for example, giving directions by pointing). Regulators support the interaction and communication between speaker and listener (for example, raising hand to manage turn-taking). Affect displays are facial expressions, which when combined with postures reflect the intensity of an emotion (for example, staring at an object and moving the body back reflect the emotion fear). Adaptors are gestures used at some point in time for personal convenience, but have turned into a habit (for example, adjusting glasses in a tensed situation).

1.2. Hand gesture recognition

Fig. 2 shows the block diagram of a typical contactless gesture recognition system. The sensor is a camera in vision-based gesture recognition systems. Berman et al. [6] reviewed different sensors used in gesture recognition systems and provided a comprehensive analysis of integration of sensors into gesture recognition systems and their impact on the system performance. Based on feature extraction, vision-based gesture recognition systems are broadly divided into two categories, appearance-based methods and three dimensional (3D) hand model-based methods. Appearance-based methods utilize features of training image to model the visual appearance, and compare these parameters with the features of test image. Threedimensional model-based methods rely on a 3D kinematic model, by estimating the angular and linear parameters of the model.

1.3. Survey and evaluation of hand gesture recognition techniques

Our study builds on top of earlier attempts to survey the field of HGR. Mitra et al. [7] provided a survey of different gesture recognition methods, covering hand and arm gestures, head and face gestures, and body gestures. The HGR methods investigated in the survey was limited to Hidden Markov Models (HMMs), particle filtering and condensation algorithms, and Artificial Neural Networks (ANNs). Hand modeling and 3D motion based pose estimation methods are reviewed in [8] (ignoring the gesture classification schemes). An analysis of sign languages, grammatical processes in sign gestures, and issues relevant to the automatic recognition of sign languages are discussed in [9]. The latest of the above papers [8] covered developments till the year 2005. The review concluded that the methods studied are experimental and their use is limited to laboratory environments.

This paper reviews recent works in HGR with a focus on the developments in the last 16 years. Algorithms utilizing conventional RGB cameras (Section 2) as well as the new generation RGB-D cameras (Section 3) are surveyed, making the review unique. The HGR methods are classified and analyzed according to the technique used for gesture classification. We perform a quantitative comparison of HGR algorithms based on different attributes of the algorithm and the experimental methodology followed in algorithm testing. A review of available hand gesture databases (Section 4) and a discussion on hand gesture recognition research (Section 5) are also provided. We hope this survey is timely, given the growing research efforts and expanding market for gestural interactive systems.

چکیده

1. مقدمه

1.1 طبقه بندی ژست ها

1.2 تشخیص ژست دست

1.3 بررسی و ارزیابی تکنیک های تشخیص ژست دست

2. تشخیص مرسوم ژست دست: روش های مبتنی بر سنسور RGB

2.1 تشخیص ژست های پویای دست

2.2 تشخیص حالات دست

3. روندهای اخیر در تشخیص وضعیت دست: روش های مبتنی بر سنسور RGB-D

3.1 روشهای مبتنی بر Kinect

3.2 سایر روشهای مبتنی بر سنسور RGB-D

4. پایگاه های داده ژست دست

4.1 مجموعه داده های Sebastien-Marcel در مورد وضعیت و ژست دست

4.2 مجموعه داده های ژست دست کمبریج

4.3. مجموعه داده های ژست دست توسط Shen و همکاران

4.4 پایگاه داده سیگنالهای حمل و نقل هوایی NATOPS

4.5 مجموعه داده های ژست توسط یون و همکاران

4.6 پایگاه داده بازی تعاملی Sebastien-Marcel

4.7 مجموعه داده ژست Keck

4.8 پایگاه داده ژست حرکتی شش بعدی

4.9 داده های ژست ChaLearn

4.10 داده های ژست چندنمایی ChaLearn

4.11 مجموعه داده های چندنمایی ChAirGest

4.12 مجموعه داده های ژست Sheffield KInect (SKIG)

4.13 مجموعه داده های ژست kinect MSRC-12

4.14 مجموعه داده های-I وضعیت دست NUS

4.15 مجموعه داده های-II وضعیت دست NUS

4.16 داده های ذخیره شده بوسیله Ren و همکاران

4.17 مجموعه داده ColorTip

4.18 مجموعه داده های حالت دست NYU

4.19 مجموعه داده های HANDS (دستان)-عمومی

4.20 مجموعه داده های ژست دست VPU

5. بحث

5.1 شناسایی تصویرگرها

5.2 مقایسه روش ها، ویژگی ها و روش های طبقه بندی

5.3 چالش ها و دستورالعمل های تحقیقاتی آینده

Abstract

1.Introduction

1.1. Taxonomy of gestures

1.2. Hand gesture recognition

1.3. Survey and evaluation of hand gesture recognition techniques

2. Conventional hand gesture recognition: RGB sensor

based methods

2.1. Recognition of dynamic hand gestures

2.2. Recognition of hand postures

3. Recent trends in hand gesture recognition: RGB-D sensor

based methods

3.1. Kinect based methods

3.2. Other RGB-D sensor based methods

4. Hand gesture databases

4.1. Sebastien-Marcel hand posture and gesture datasets

4.2. Cambridge hand gesture dataset

4.3. Gesture dataset by Shen et al.

4.4. NATOPS aircraft handling signals database

4.5. Gesture dataset by Yoon et al.

4.6. Sebastien Marcel interact play database

4.7. Keck gesture dataset

4.8. 6D motion gesture database

4.9. ChaLearn gesture data

4.10. ChaLearn multi-modal gesture data

4.11. ChAirGest multi-modal dataset

4.12. Sheffield KInect gesture (SKIG) dataset

4.13. MSRC-12 kinect gesture dataset

4.14. NUS hand posture dataset-I

4.15. NUS hand posture dataset-II

4.16. Posture dataset by Ren et al.

4.17. ColorTip dataset

4.18. NYU hand pose dataset

4.19. General-HANDS data-set

4.20. VPU hand gesture dataset

4.21. Dataset by Kawulok et al.

4.22. ASL Finger Spelling Dataset

4.23. Other related hand databases

5. Discussion

5.1. Recognition of illustrators

5.2. Comparison of approaches, features, and classification methods

5.3. Challenges and future research directions

References